Современные тенденции в науке отмечаются активным взаимодействием различных дисциплин, особенно заметно слияние математики и физики с другими областями знания. Междисциплинарные связи служат конкретным отражением интеграционных процессов, происходящих как в научной сфере, так и в социальной жизни, благодаря которым задачи решаются на качественно новом уровне. Это взаимодействие не только способствует эффективному решению сложных вопросов, но и создает основу для комплексного восприятия, подхода и нахождения решений для актуальных проблем современной реальности.

Среди множества форм междисциплинарного взаимодействия можно выделить три ключевых направления: совместное глубокое исследование одного и того же объекта различными науками, применение методологических подходов одной науки для анализа различных объектов в других областях знаний, а также обращение разных наук к одними и теми же теориям и законам для изучения различных предметов. [1].

Если исследовать и рассмотреть связь между информатикой и физикой, которая необходима для глубокого понимания самой дисциплины информатики, то можно выявить достаточно большое количество совпадений и аналогий. Согласно словарю иностранных терминов, информатика (происходит от слов «информация» и «автоматика») представляет собой область знаний, посвящённую изучению общих характеристик и структуры информации. Также она занимается закономерностями и основными принципами, касающимися её создания, обработки, хранения, передачи и применения в различных сферах человеческой деятельности. [2].

Исследователи классифицируют информацию как одну из основных категорий наряду с материей, энергией и временем, и эти категории находятся в тесной взаимосвязи. В зависимости от контекста и области знаний информация может восприниматься и интерпретироваться по-разному, что приводит к множеству подходов к ее измерению и различным методам определения количественных характеристик информации. Количество информации — это главный количественный показатель, который адекватно отражает разнообразие, сложность, структуру (или упорядоченность), определенность и выбор состояний анализируемой системы. Когда мы изучаем определенную систему, имеющую n возможных состояний, важной задачей становится оценка этого выбора или результата. В этом контексте мера информации может служить подходящим инструментом для такой оценки. Мера — непрерывная действительная неотрицательная функция, определенная на множестве событий и являющаяся аддитивной (суммарной). Меры могут быть статические и динамические, в зависимости от того, какую информацию они позволяют оценивать: статическую или динамическую.

В процессе выполнения информационных операций происходит передача данных из одной точки в другую, а также во временном аспекте, от источника к получателю. Для этих целей применяются различные системы знаков или символов, которые могут быть как естественного, так и искусственного (формального) типа. Эти знаки служат для представления информации в форме сообщения. Например, Клод Шеннон, который стал основоположником теории информации, утверждает, что информация — это уменьшение неопределенности знаний субъекта по поводу какого-либо вопроса.

С другой стороны, всё, что нас окружает, делится на физические объекты и физические поля. Любой физический объект, находясь в состоянии движения или изменения каких-либо собственных характеристик, постоянно осуществляет энергетический обмен с окружающей средой или взаимодействующими телами, или же преобразует энергию из одного вида в другой. Каждый тип энергетического обмена сопровождается возникновением сигналов, что означает, что все сигналы имеют материальную и энергетическую основу. Когда сигналы взаимодействуют с материальными объектами, в этих объектах происходят изменения некоторых их характеристик, что и называется регистрацией сигналов. Эти изменения можно отслеживать, измерять или фиксировать разными методами. В процессе возникают и фиксируются новые сигналы, то есть, создаются новые данные.

Для того чтобы определить количество информации, следует ознакомиться с классификацией мер информационных данных. Всего существует три меры информации: синтаксическая, семантическая и прагматическая [3].

Последние две меры являются относительными концепциями, поскольку семантическая мера предназначена для оценки смыслового наполнения информации и связывает специфические параметры данных с возможностями пользователя в их обработке. В то время как прагматическая мера информации определяет количественную оценку полезности данных для достижения конкретных целей. Это понятие напрямую связано с возможностью системы или пользователя использовать определенный объем информации в рамках конкретной области проблемы.

Синтаксическая мера функционирует с данными, которые не передают смысловые связи с объектом. Эта мера исследует тип носителя информации, методы её представления и кодирования, а также скорость передачи и обработки данных. В данном контексте мера определяется как объем информации — это объем памяти, необходимый для хранения сведений об объекте. Информационный объем соответствует количеству единиц двоичной системы, которые используются для кодирования исследуемого сообщения, и измеряется в битах.

Для того чтобы определить синтаксическое количество информации, обратимся к физике. Понятие энтропии, рассматриваемое в разделе термодинамики как ни странно очень отражает характеристики информации. Само понятие энтропии — это мера неопределённости состояния системы. В данном случае, это именно знания о состоянии отдельных элементов системы и общем ее состоянии в целом. Тогда количество информации — это изменение меры неопределённости системы, то есть изменение (увеличение или уменьшение) энтропии.

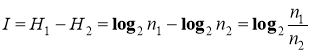

Энтропия опыта равна той информации, которую мы получаем в результате его осуществления. Информация I — содержание сообщения, понижающего неопределенность некоторого опыта с неоднозначным исходом; убыль связанной с ним энтропии является количественной мерой информации. Если H 1 — начальная энтропия (до проведения опыта), H 2 — энтропия после проведения опыта, то информация

где

В случае, когда получен конкретный результат, H 2 = 0, количество полученной информации совпадает с начальной энтропией и подсчитывается по формуле Хартли.

Итак, мы ввели меру неопределенности — энтропию и показали, что начальная энтропия (или убыль энтропии) равна количеству полученной в результате опыта информации. Важным при введении какой-либо величины является вопрос о том, что принимать за единицу ее измерения. Очевидно, значение H будет равно 1 при n = 2. Иначе говоря, в качестве единицы принимается количество информации, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов, такая единица количества информации называется «бит».

При реализации информационных процессов информация передается в виде сообщения, представляющего собой совокупность символов какого-либо алфавита. При этом каждый новый символ в сообщении увеличивает количество информации, представленной последовательностью символов данного алфавита. Если теперь количество информации, содержащейся в сообщении из одного символа, принять за единицу, то объем информации (данных) V в любом другом сообщении будет равен количеству символов, разрядов, в данном сообщении. Так как одна и та же информация может быть представлена многими разными способами, например, разными алфавитами, то и единица измерения данных соответственно будет меняться.

Популярность энтропии связана с ее важными свойствами: универсальностью и аддитивностью. Со своей стороны, информация оказалась характеристикой степени зависимости некоторых переменных. Ее можно сравнить с корреляцией, но если корреляция характеризует лишь линейную связь переменных, информация характеризует любую связь.

Литература:

- Атанов И. В., Капустин И. В., Никитенко Г. В., Скрипкин В. С. Межпредметные cвязи в учебном процессе высшего учебного заведения // Современные проблемы науки и образования, 2013. № 6. C. 355.

- Крысин Л. П. Иллюстрированный толковый словарь иностранных слов. М.: Эксмо, 2011. 294 с.

- Михайлов А. И., Черный А. И., Гиляревский Р. С. Основы информатики. — 2-е изд., перераб. и доп. М.: Наука, 1968. 756 с.

- Блюменфельд Л. А. Информация, термодинамика и конструкция биологических систем // Соросовский Образовательный Журнал, 1996. № 7. С. 88–92.

- Бекман И. Н. Информация, информатика и информационные технологии Курс лекций 2014. [Электронный ресурс]. URL: http://beckuniver.ucoz.ru/index/kurs_lekcij_informatika.