Исследование и разработка математической модели метеопрогноза

Автор: Юркин Вадим Михайлович

Рубрика: 1. Информатика и кибернетика

Опубликовано в

Дата публикации: 01.07.2016

Статья просмотрена: 574 раза

Библиографическое описание:

Юркин, В. М. Исследование и разработка математической модели метеопрогноза / В. М. Юркин. — Текст : непосредственный // Технические науки: проблемы и перспективы : материалы IV Междунар. науч. конф. (г. Санкт-Петербург, июль 2016 г.). — Санкт-Петербург : Свое издательство, 2016. — С. 30-37. — URL: https://moluch.ru/conf/tech/archive/166/10833/ (дата обращения: 24.04.2025).

В данной статье исследованы математические модели построения метеопрогноза, основанные на работе нейронных сетей, которые позволяют вычислить предположительные метеопараметры искомой местности на основе предыдущих метеоданных. Предложен новый метод группировки нейронных сетей для получения более точного результата на выходе. Представлен алгоритм, опираясь на который, исходя из результатов исследования, был получен наиболее точный метеопрогноз. Данный алгоритм может быть использован в широком спектре ситуаций, таких как: получение данных для эксплуатации оборудования в данной локации, исследование метеорологических параметров локации и т. п.

Для построения данной модели были использованы данные полученные с персональных погодных станций (ППС) компании WeatherUnderground и Национальной Цифровой Метеопрогнозной Базы Данных США (USNationalDigitalForecastDatabase (NDFD)). А также, для сравнения результатов с уже имеющимися на рынке продуктами, была использована удаленная обучающаяся машина компании Google.

Алгоритм построения прогнозной модели затрагивает несколько локаций расположенных на территории США для сравнения эффективности в различных погодных зонах. А также были рассмотрены разные методы обучения машины для получения самого эффективного результата метеопрогноза.

Одной из самых распространенных проблем обеспечения научной, производственной и других деятельностей человека была и остается проблема своевременного получения информации об окружающей среде в необходимый момент времени. Особенно важной данная проблема становится для поддержки технических систем (ТС), зависимых от метеоусловий, и работающих в автономном режиме. Их параметры не могут быть откалиброваны в зависимости от метеоусловий на данный момент, что ставит перед создателями таких систем необходимость решения проблемы предсказания метеоусловий на продолжительном отрезке времени. В то время как предсказание значений для однопараметрических технических систем (ОТС) не представляет особых проблем, МТС требует вдумчивого подхода к созданию алгоритма построения прогнозной модели, что делает данную проблему весьма актуальной.

На данный момент известны различные методы и средства получения и прогнозирования метеоданных на искомой локации (её параметрах), таких как:

- Исследование погодных явлений на текущей локации при помощи физических законов. (WeatherResearch & ForecastingModelhttp://www.wrf-model.org)

- Исследование погодных условий при помощи математических преобразований данных полученных с Зондов.

Целью данногоисследования является описание и анализ алгоритма построения прогнозной модели для МТС для конкретной местности на примере данных полученных с ППС для определенных регионов при помощи самообучающихся машин, а так же их сравнение.

Современное количество решений проблемы построения метеопрогнозных моделей и их анализа поражают. Одним из самых успешных, но в то же время, самых затратных решений является решение предоставленное WeatherResearch & Forecasting, которое сводится к построению математической модели физических явлений и применение на текущих данных определённой локации, однако такой подход редко даёт точный результат, так как требует огромных ресурсов для решения и требует постоянного расчёта с учётом меняющихся параметров системы, а также требует таких-же построений моделей для соседних регионов, что увеличивает расходы на точный прогноз экспоненциально, а также не учитывает колебания вызванные многими параметрами, которые не могут зафиксировать зонды.

Нейронные сети используют один из наиболее перспективных методов прогнозирования МТС, которым является математическая экстраполяция, так как этот метод основывается только на статистическом анализе данных. Минусом же данного подхода является невозможность экстраполировать развитие процесса вперед на длительный временной интервал, для этого они строят закономерности между входными и выходными значениями, опираясь на обучающие данные, в случае с метеопрогнозом такими данными являются предыдущие наблюдения, собранные ППС.

В данной работе используется обучающая парадигма, в которой конечное количество нейронных сетей обучаются по одинаковым данным для получения искомого результата, такая парадигма называется группировкой нейронных сетей.

-

Описание и применение нейронных сетей

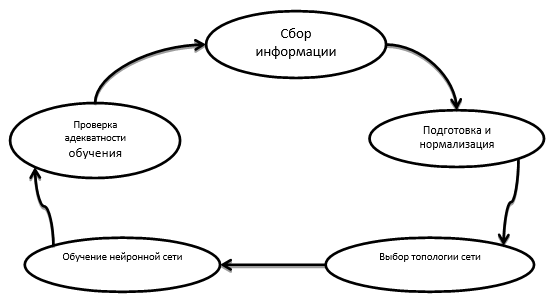

- Этапы построения нейронной сети

На первом этапе проводится нормализация и отсеивание поврежденных данных, в данной работе данные получаются из общедоступного источника компании WeatherUnderground и USANationalDigitalForecastDataBase. Процесс нормализации целиком зависит от выбора топологии на предыдущем шаге, к примеру: для RBFN необходимо формировать данные таким образом, чтобы в обучающих данных содержался правильный ответ.

На втором этапе выбирается математическая модель, строящая функциональные зависимости между входными и выходными данными, позволяющая получить необходимый результат. В данной работе рассмотрены три классических топологии: D-PNN, RBFN и MLPN, а также предложена новая: метод группировки нейронных сетей.

На третьем этапе производится обучение нейронной сети посредством подачи на входы математической модели пронормированных данных. Нейронная сеть строит функциональные зависимости между данными и в конечном итоге на выходе получаем функцию зависимости входных и выходных значений при определенном обучающем наборе данных.

На четвертом этапе проводится проверка полученной модели на точность и адекватность. При прогнозировании нужно точно установить понятие необходимой точности результата, в данной работе модель считается адекватной при точности прогноза в 10 %, а оценка точности вычисляется как процентное соотношение между полученными моделью и реальными данными.

Рис. 1. Этапы построения нейронных сетей

1.2 Математические модели использованных нейронных сетей

Первая нейронная сеть, основанная на решении дифференциального многочлена (DifferentialpolynomialneuralnetworkD-PNN). D-PNN описывает функциональные зависимости входных параметров и исследование их свойств, которые часто используют для прогноза, анализа временных рядов и выявления скрытых взаимосвязях в данных [1]. Того удаётся достичь путём шаблонизирования зависимостей между данными. Главной идеей D-PNN является аппроксимация функций, описываемых дифференциальными уравнениями, которые описывают взаимосвязи между входными параметрами системы. Связи между данными описываются аналогично, представленному в 1971 году, многочлену Колмогорова-Габора [2]:

![]() , (1)

, (1)

где: m-кол-во переменных, ![]() - вектора входных переменных,

- вектора входных переменных,

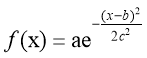

Второй нейронной сетью является нейронная сеть, использующая радиально-базисные функции как активационные. Такая сеть называется сетью радиально-базисных функций (Radial Basis Function Network RBFN) [3]. RFBN очень популярна для аппроксимации функций, предсказаний ременных рядов и классификаций. В таких сетях очень важно определить количество нейронов в скрытом слое (hidden layer), так как это сильно влияет на сложность сети и её обобщающие возможности. В скрытом слое каждый нейрон имеет активирующую функцию. Гауссова функция, которая имеет параметр управляющий поведением функции, является наиболее предпочтительной функцией активации [4].

(2)

(2)

где: a, b, c — вещественные числа.

Третья нейронная сеть основана на Многослойном перцептроне (MultulayerperceptronnetworkMLPN) [5]. Этот тип известен тем, что требует наличие желаемого результата в массиве обучающих данных, в нашем случае, необходимо подавать дополнительное значение, которое будет являться правильным результатом для входных данных. Иными словами, данная модель связывает входные значения с их результатом, используя исторические данные погоды, для предсказания в будущем, что очень важно при нормализации данных.

|

Принцип построения модели |

Математическое описание |

Входная информация |

Выходная информация |

|

D-PNN |

|||

|

Аппроксимация функций описываемых дифференциальными уравнениями, которые описывают взаимосвязи между входными параметрами системы. |

|

X(1), x(2), x(3), x(4)…x(n) |

X(n+1) |

|

RBFN |

|||

|

Аппроксимация неизвестного решения с помощью функций специального вида, аргументами которых является расстояние. |

|

X(1), x(2), x(3), x(4)…x(n) |

X(n+1) |

|

MLPN |

|||

|

Аппроксимация неизвестного решения с помощью нелинейных функций. |

|

X(1), x(2), x(3), x(4)…x(n) |

X(n+1) |

1.3 Описание математической модели группировки нейронных сетей

Группировка нейронных сетей — это подход к построению самообучающейся машины, в которой совокупность конечного числа нейронных сетей обучается по одной и той же задаче. Этот подход берёт своё начало от Хансена и Саламона [6] в работе, которой показывает, что система нейронных сетей может существенно улучшиться при подходе группировки, а это значит, что и предсказания которые производит такая машина намного точнее. В целом, группировку нейронных сетей можно разделить на два этапа: обучение нескольких нейронных сетей и затем объединение и обработка предсказаний каждой. Результатом работы такой системы является усредненное значение выводов каждой нейронной сети в отдельности, объединенное с функцией, описывающей сравнительное отклонение значений относительно друг друга, полученное на этапе обучения. Результаты работы таких систем существенно повышают точность прогнозов.

В данной работе будет рассмотрен новый подход для обучения данных систем. Весовые коэффициенты пропорциональны соответствующим выходным значениям. Суть подхода в том, чтобы определить какая нейронная сеть выдаёт более точный прогноз. Рассмотрим на примере: предположим, что имеется две нейронные сети, которые должны выполнить простую классификационную задачу, если на вход подано значение 1, то выдать единицу, если 0, то выдать 0. Пусть такие нейронные сети на определённом шаге выдают 0,6 и 0,9 соответственно. В таком случае вторая машина получает намного более достоверные данные, так-как 0,9 ближе к единице.

Сети обратного распространения устанавливают начальные весовые коэффициенты случайным образом, чтобы уменьшить среднеквадратичное отклонение. Разница в начальных весовых коэффициентах даёт разные результаты. Таким образом, группировка нейронных сетей интегрируют эти независимые сети для улучшения обобщающей способности. Этот метода также гарантирует увеличение точности с точки зрения среднеквадратичного отклонения [7].

Рассмотрим одну нейронную сеть, которая обучается на некотором массиве данных. Пусть x — входной вектор, который появляется впервые в данной сети, а d — желаемый результат. x и d представляют реализацию случайного вектора X и случайной величины D соответственно. Пусть F(x) — функция ввода-вывода, реализованная с помощью сети. Тогда:

![]() (3)

(3)

где: E [D|X=x] — математическое ожидание,

![]() (4)

(4)

и ![]() - разница:

- разница:

![]() (5)

(5)

Ожидание ![]() по множеству D называется множеством, охватывающим распределение всех обучающих данных, таких как входные и выходные значения, и распределение всех начальных условий. Существует несколько способов индивидуального обучения нейронной сети и несколько способов группировки их выходных данных. В данной работе предполагается, что сети имеют одинаковые конфигурации, но начинают своё обучение с разных начальных условий. Для объединения выходных данных группы нейронных сетей используется усредненную простую группировку. Пусть

по множеству D называется множеством, охватывающим распределение всех обучающих данных, таких как входные и выходные значения, и распределение всех начальных условий. Существует несколько способов индивидуального обучения нейронной сети и несколько способов группировки их выходных данных. В данной работе предполагается, что сети имеют одинаковые конфигурации, но начинают своё обучение с разных начальных условий. Для объединения выходных данных группы нейронных сетей используется усредненную простую группировку. Пусть ![]() - множество всех начальных условий,

- множество всех начальных условий, ![]() - усредненное значение ввода-вывода функций сети. Тогда по аналогии с уравнением 3 получаем:

- усредненное значение ввода-вывода функций сети. Тогда по аналогии с уравнением 3 получаем:

![]() (6)

(6)

где ![]() — квадрат отклонения, определяемый множеством

— квадрат отклонения, определяемый множеством ![]() :

:

![]() (7)

(7)

и ![]() - соответствующая разница:

- соответствующая разница:

![]() (8)

(8)

Математическое ожидание ![]() берется для множества

берется для множества ![]() .

.

Из определения множества D можно представить его в качестве множества начальных условий

![]() (9)

(9)

где ![]() - квадрат отклонения, определяемый множеством D’:

- квадрат отклонения, определяемый множеством D’:

![]() (10)

(10)

и ![]() - соответствующая разница:

- соответствующая разница:

![]() (11)

(11)

Из определения множеств D, ![]() , D’ очевидно, что:

, D’ очевидно, что:

![]() (12)

(12)

Из этого следует, что уравнение 10 может быть переписано в эквивалентной форме:

![]() (13)

(13)

Учитывая разницу ![]() из уравнения 11, так как разница случайной переменной эквивалентна среднеквадратичному значению случайной переменной, вычесть её квадрат отклонения, получаем:

из уравнения 11, так как разница случайной переменной эквивалентна среднеквадратичному значению случайной переменной, вычесть её квадрат отклонения, получаем:

или

![]() (15)

(15)

Стоит учесть, что среднеквадратичное значение функции F(x) на множестве D должно быть больше или равно среднеквадратичному значению функции ![]() на множестве D’.

на множестве D’.

![]() (16)

(16)

Учитывая уравнения 32 и 33:

![]() (17)

(17)

Отсюда, учитывая уравнения 13 и 17 можно сделать два вывода:

-

Смещение функции

, относящееся к нескольким классифицирующим системам точно такое же, как смещение функции F(x) относящееся к одной нейронной сети.

, относящееся к нескольким классифицирующим системам точно такое же, как смещение функции F(x) относящееся к одной нейронной сети.

-

Разница функции

меньше чем функции F(x).

меньше чем функции F(x).

Группировка линейных нейронных сетей продемонстрировала повышение производительности по отношению к отдельным сетям. В данной работе представлена группировка нелинейных упреждающих сетей, порожденных конструктивным алгоритмом. Аналогичный подход был применён для, рассмотренных ранее, D-PNN, RBGN, MLP.

- Обзор результатов работы рассмотренных математических моделей

Таким образом, входными параметрами будут исторические данные, полученные с ППС и результатом обучения будет функция зависимости этих параметров друг от друга, тогда при вводе достаточных данных в запросе на прогноз в будущем мы получим необходимые нам данные. Для построения прогноза на основе вышеупомянутых математических моделей нужно упорядочить полученные данные в виде массива перечисляемых параметров:

Таблица 2.1

Пример входных данных для обучения

|

Temp |

City |

Daytime |

Day_of_year |

Year |

Humidity% |

WindSpeed kph |

Pressure in mBar |

WeatherConditions |

|

12.0 |

1 |

3 |

1 |

2001 |

14 |

5 |

1200 |

2 |

|

12.5 |

1 |

4 |

1 |

2001 |

15 |

4 |

1150 |

3 |

|

… |

… |

… |

… |

… |

… |

… |

… |

… |

В данном случае, так как модель оперирует числовыми данными, городам и описанию погоды были выделены определённые индексы, например 1 в графе города означает Лос-Анджелес. В процессе исследования было проведено несколько способов обучения, путём манипуляции подаваемы значений.

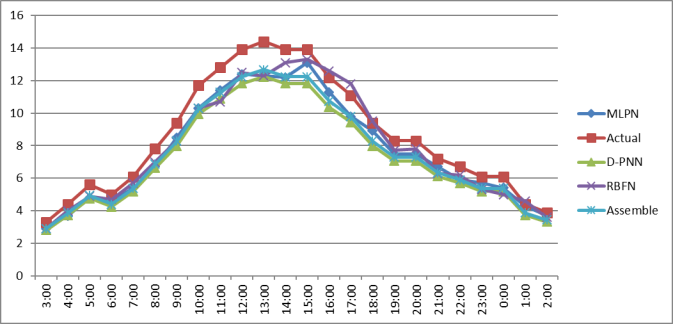

Определим, как работают модели для разных сезонов, для этого подаём на вход данные за 5 лет и сравним полученные данные с реальными значениями за разные периоды (0:00–23:00 1-го января 2015, 0:00–23:00 1-го апреля 2015, 0:00–23:00 1-го июля 2015 и 0:00–23:00 1-го октября 2015).

Таблица 2.2

Средние отклонения прогнозных значений температуры

|

|

D-PNN |

RBFN |

MLPN |

Assemble |

|

Зима |

17 % |

14 % |

14 % |

12 % |

|

Весна |

15 % |

13 % |

12 % |

10 % |

|

Лето |

13 % |

15 % |

10 % |

8 % |

|

Осень |

13 % |

15 % |

11 % |

9 % |

Рис. 2: График прогнозных значений, полученных каждым методом на 1-ое января 2015 года

Таким образом, созданный нами метод группировки нейронных сетей имеет лучшую точность во всех сезонах и имеет приемлемую точность ![]() 91 %.

91 %.

Заключение

В данной статье был разработан и исследован алгоритм построения метеопрогноза при помощи группировки нейронных сетей. Был рассмотрен алгоритм, построения математической модели предсказания будущих состояний параметров метеосистемы на основе Дифференциального многочлена, Радиально-базисных функций, Многослойного перцептрона и группировки нейронных сетей. Можно сделать вывод, что комбинация математических моделирования и «правильных» входных данных, связанных с погодными явлениями могут сделать метеопрогнозную модель более точной.

Автор данной статьи продолжает исследование моделей метеопрогноза путём усовершенствования не только порядка и точности входных данных, но и изменения математической основы построения самой модели.

Литература:

- Galkin I., Polynomial neural networks, 2000, стр. 307

- Zyavka L., Polynomia; neural network. Proceeding of the 7th European Conference Information and Communication Technologies, 2005, стр. 277–280.

- Obitko M., Generic algorithm, 2006, стр.205

- Paul J. and J. W. Sandberg, Universal approximation using RBFN, 1996, стр. 506–507

- Zhou Z., Ensemble neural networks, 2003, стр. 239–263

- Zurada J., Introducing to artificial neural systems., 1993, стр. 283–291

- Luo. L, Application of radial basis function, 2010, стр. 97–117